Les deepfakes sont des contenus audio, visuels ou vidéo générés ou modifiés dans le but de simuler la voix, le visage ou les gestes d’une personne réelle. Ce terme est issu de la contraction de « deep learning » et « fake » et désigne une technologie qui s’est démocratisée depuis la fin des années 2010. À leurs débuts, les deepfakes étaient principalement utilisés dans les domaines de la recherche ou du divertissement, permettant par exemple de remplacer le visage d’un acteur par celui d’un autre dans une scène de film. Avec l’amélioration des techniques d’intelligence artificielle et la démocratisation des outils de création, les deepfakes ont investi d’autres sphères, jusqu’à devenir accessibles au grand public via des applications ou des plateformes en ligne. Aujourd’hui, la prolifération de contenus falsifiés menace la confiance dans l’information, alimente la désinformation et ouvre la voie à des usages malveillants qui concernent aussi bien les sphères politiques, économiques que personnelles.

Les risques associés aux deepfakes : de l’arnaque à la déstabilisation globale

L’un des principaux dangers liés aux deepfakes réside dans leur capacité à brouiller la frontière entre le réel et le fictif. En imitant parfaitement la voix ou le visage d’une personnalité publique, il devient possible de fabriquer des déclarations trompeuses, d’altérer le cours d’un débat politique ou de manipuler l’opinion publique. Ces manipulations peuvent viser à discréditer un adversaire, influencer une élection ou provoquer une crise de confiance dans les institutions.

Dans la sphère économique et professionnelle, les deepfakes sont surtout utilisés à des fins de fraude financière : des criminels les exploitent pour imiter la voix ou l’apparence de dirigeants d’entreprise, ordonnant de faux virements ou accédant à des informations sensibles. Dans la sphère privée enfin, les deepfakes visent à harceler, venger ou escroquer, en particulier par la création de contenus intimes truqués ou par l’imitation vocale lors de tentatives d’arnaques.

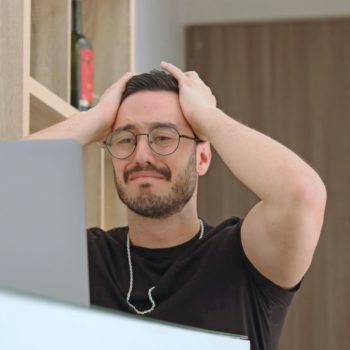

La menace ne se limite donc plus à la sphère médiatique : elle touche directement la vie privée, la sécurité numérique et la stabilité sociale. Selon une étude IFOP menée en 2024, 33% des Français s’estiment capables de discerner un contenu photo ou vidéo générée par une intelligence artificielle d’un contenu réel. Les jeunes (moins de 35 ans), plus confiants, sont 55% à s’en estimer capables. Pourtant, lorsque l’on confronte les Français à cinq deepfakes, la quasi-totalité d’entre eux (94%) se trompent au moins une fois sur la véracité des photographies.

Les tentatives de détection

Face à cette menace croissante, plusieurs approches techniques ont vu le jour pour détecter les contenus deepfake. En effet, ils présentent souvent des anomalies subtiles, appelées artéfacts, résultant de manipulations numériques. Les solutions les plus répandues s’appuient sur l’intelligence artificielle pour analyser et détecter ces anomalies. Certains outils examinent les micro-expressions faciales, les incohérences dans l’éclairage ou les artefacts numériques invisibles à l’œil nu. Des systèmes de reconnaissance biométrique peuvent repérer des incohérences dans les mouvements oculaires ou le clignement des yeux, souvent mal reproduits par les algorithmes de génération. Dans le domaine audio, des logiciels spécialisés comparent les spectres vocaux ou détectent des patterns trop réguliers pour être humains. Enfin, certaines entreprises et chercheurs explorent des solutions fondées sur la blockchain ou la signature numérique, visant à certifier l’authenticité des contenus dès leur création, afin de garantir leur traçabilité.

Les limites de la détection automatisée

Malgré les progrès réalisés, les outils de détection restent confrontés à de nombreuses limites. L’une des plus grandes difficultés tient à la vitesse à laquelle les technologies de génération évoluent. À chaque nouvelle avancée dans la création de deepfakes, les méthodes de détection doivent être ajustées, dans une course perpétuelle entre offense et défense. De plus, les détecteurs basés sur l’IA dépendent étroitement de la qualité et de la diversité des bases de données utilisées pour leur entraînement. Des biais dans ces données peuvent rendre les systèmes inefficaces dans certains contextes culturels ou linguistiques et le risque non négligeable de faux positifs et de faux négatifs nuit à la fiabilité des analyses automatisées, surtout dans des situations juridiques ou médiatiques sensibles. Enfin, beaucoup de ces outils restent peu accessibles au grand public, ou nécessitent des compétences techniques avancées pour être utilisés correctement, ce qui freine leur adoption à large échelle.

Ainsi, pour être globale, la lutte contre la désinformation par deepfake ne pourra pas reposer uniquement sur des solutions techniques, aussi avancées soient-elles. Dans un monde où l’image et le son peuvent être falsifiés en quelques clics, la vigilance collective est notre meilleure défense.

Cela nécessite une approche combinant innovation technologique, régulation adaptée et éducation numérique pour former, dès le plus jeune âge, à développer notre esprit critique face aux différents contenus que nous consommons quotidiennement.

Pour en savoir plus, contactez-nous !